6月10日凌晨1点,苹果召开WWDC25开发者大会。与此前业界预测的差别不大,本届WWDC大会主要聚焦设计更新和AI功能。苹果推出了操作系统设计语言Liquid Glass,将操作系统的版本改用年份命名。

AI方面,去年苹果在WWDC上公布了AI战略,宣布将Apple Intelligence集成到包括Siri在内的一系列程序中,并与OpenAI合作将ChatGPT引入iPhone等设备。相比之下,今年苹果并未拿出大刀阔斧地AI更新,而是介绍了一些较为实用的功能。

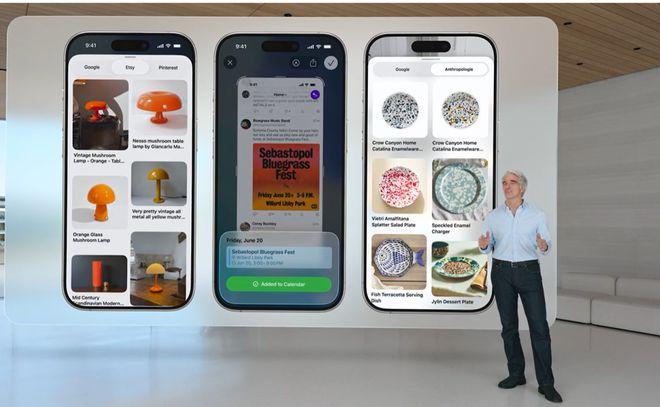

具体而言,苹果iOS26将推出基于Apple Intelligence的实时翻译功能,该功能集成到信息、电话、FaceTime通话中,可实现文本和语音的即时多语言翻译。iOS26还推出了视觉智能功能,可实现跨App内容识别,例如用户按住相机控制并将手机对准某个物体,轻点就可在浏览器中搜索类似图像,或者用相机对准某个餐厅就能调出该餐厅在网站上评分。

除了iOS的AI更新,据苹果介绍,watchOS26手表端也支持实时翻译。MacOS则推出智能操作Shortcuts和Spotlight升级,让用户可以通过语言创建自动化流程,也可以在桌面搜索引擎Spotlight中用自然语言快速启动多种功能。

此次比较重要的AI更新还包括,苹果加深了与OpenAI的合作,宣布将ChatGPT的图像生成功能添加到Image Playground应用程序中。苹果还向第三方开发者开放了Apple Intelligence核心大语言模型。新发布的基础模型框架Foundation Models允许开发者访问苹果的设备端基础模型,并借助该框架将苹果的设备内置模型集成到App中。“基础模型框架让开发者能使用我们的模型,并以纯文本格式获得回应,或将这些模型用作结构化Swift(一种开发语言)数据。”苹果相关负责人表示。